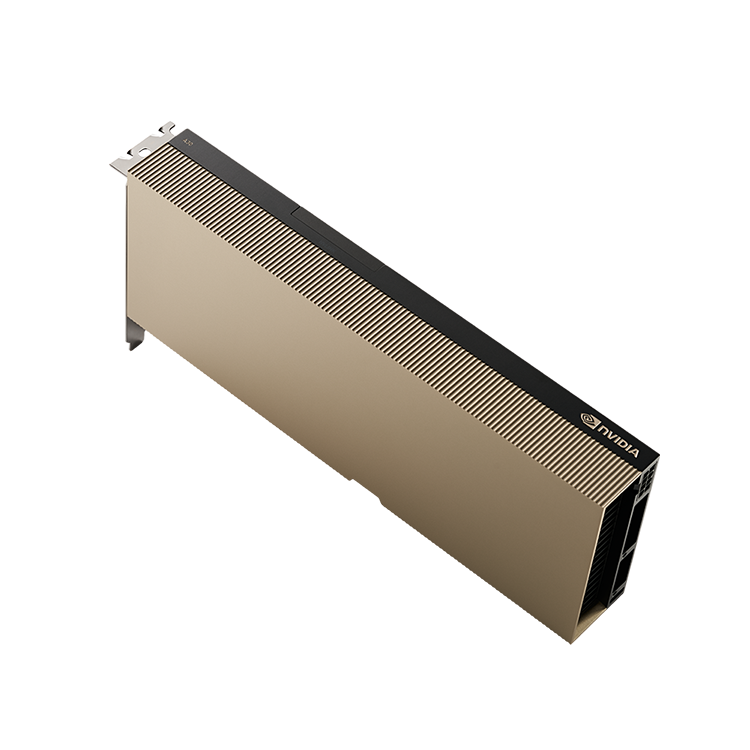

NVIDIA A30

2024年10月販売終了

メインストリーム エンタープライズ サーバーのための多彩なコンピューティング高速化

NVIDIA A30 Tensor コア GPU は、企業のあらゆるワークロードのパフォーマンスを高速化します。

NVIDIA Ampere アーキテクチャの Tensor コアとマルチインスタンス GPU (MIG) で、大規模な AI 推論やハイパフォーマンス コンピューティング (HPC) アプリケーションといった、多様なワークロードを安全に高速化します。PCIe フォーム ファクターに高速のメモリ帯域幅と少ない電力消費が組み合わされており、メインストリーム サーバーに最適です。A30 はエラスティック データ センターを実現し、企業に最大限の価値をもたらします。

製品情報インデックス

- 製品について

- 製品サポート・ダウンロードなど

主な特長

仕様

| モデル | NVIDIA A30 |

|---|---|

| FP64 | 5.2 teraFLOPS |

| FP64 Tensor コア | 10.3 teraFLOPS |

| FP32 | 10.3 teraFLOPS |

| TF32 Tensor コア | 82 teraFLOPS | 165 teraFLOPS *1 |

| BFLOAT16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS *1 |

| FP16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS *1 |

| INT8 Tensor コア | 330 TOPS | 661 TOPS *1 |

| INT4 Tensor コア | 661 TOPS | 1321 TOPS *1 |

| メディア エンジン | 1 optical flow accelerator(OFA) 1 JPEG デコーダー(NVJPEG) 4 ビデオ デコーダー(NVDEC) |

| GPU メモリ | 24GB HBM2 |

| GPU メモリ帯域幅 | 933GB/s |

| 相互接続 | PCIe Gen4: 64GB/s 第3世代 NVLINK: 200 GB/s *2 |

| フォーム ファクター | デュアルスロット、フルハイト、フルレングス(FHFL) |

| 最大熱設計電力(TDP) | 165W |

| マルチインスタンス GPU(MIG) | 6 GB の GPU インスタンスが 4 つ 12 GB の GPU インスタンスが 2 つ 24 GB の GPU インスタンスが 1 つ |

| 仮想 GPU(vGPU) ソフトウェア サポート | VMware 向け NVIDIA AI Enterprise NVIDIA 仮想コンピューティング サーバー |

*1 疎性あり

*2 最大 2 つの GPU の NVLink ブリッジ

価格表

モデル

標準価格

NVIDIA A40

オープン

この製品の保証内容

この製品を利用した導入事例

この製品に付けられたタグ一覧

この製品と同じカテゴリーの製品

その他カテゴリーから探す

製品・ソリューションを探す

- 製品カテゴリーから探す

- 分野別ソリューションから探す

- 目的から探す